Gemma 2 は 2D AI シーンに突如登場し、大きな話題を呼んでいます。この小さなモデルは、小さなパッケージに良いものが入っていることを証明しており、テクノロジーの世界で本格的な議論を巻き起こしています。

Google の最新の発明である Gemma 2 2B は、わずか 26 億のパラメータを持つコンパクトな言語モデルです。サイズは小さいものの、この AI パワーハウスは、より大きな兄弟に匹敵します。Gemma 2 2B は、言うだけでなく、実際に行動し、その 10 倍のサイズのモデルに匹敵し、さらにはそれを上回ります。

ジェマ2 2Bの輝かしいパフォーマンス

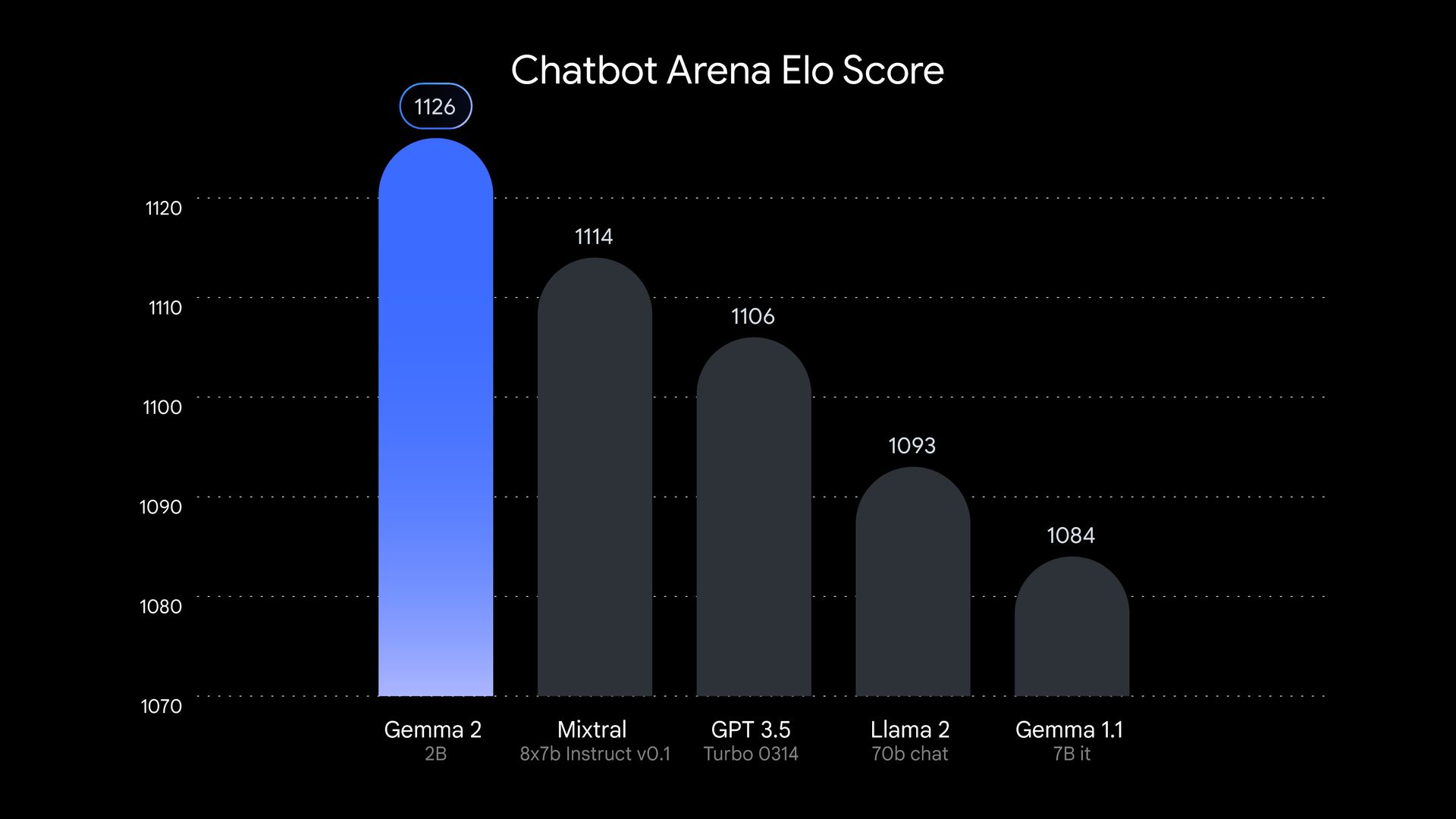

ジェマ2 2BがAI界の大きな勢力ではないことははっきりさせておきましょう。このモデルはテストされ、輝かしい結果を残しました。独立AI研究グループLMSYSが実施したテストでは、ジェマ2 2Bは印象的なスコアを獲得しました。 1130ポイント 評価分野では、この小さな逸品は、GPT-3.5-Turbo-0613 や Mixtral-8x7B などの有名製品よりも優れたパフォーマンスを発揮しました。

しかし、Gemma 2 2B の性能はそれだけではありません。他の分野でも優れていることが示されています。さまざまなトピックを理解して推論するモデルの能力をテストする MMLU ベンチマークでは、Gemma 2 2B は 56.1 ポイントを獲得しました。コーディングに関しては、MBPP テストで 36.6 ポイントを獲得しました。これらの数値は、前モデルからの飛躍的な進歩を表しています。

では、Google はこの小さな驚異をどのように作成したのでしょうか。Gemma 2 2B は、Google の高度な TPU v5e ハードウェアを使用して、2 兆トークンの膨大なデータセットでトレーニングされました。このトレーニング プロセスにより、モデルはコンパクトなフレームに大量の情報を詰め込むことができました。Gemma 2 2B は多言語対応で、世界中で潜在的な使用例が拡大しています。これにより、国際的なプロジェクトに取り組む開発者や研究者にとって多目的なツールになります。

Gemma 2 2B の成功は、AI では大きいほど良いという考え方に疑問を投げかけています。その素晴らしいパフォーマンスは、適切なトレーニング手法、効率的なアーキテクチャ、高品質のデータがあれば、小型モデルでもその重量クラスをはるかに超える性能を発揮できることを示しています。この開発により、AI 研究の焦点は、大型モデルの作成から、より小型で効率的なモデルの改善へと移行する可能性があります。これは、この分野に広範囲にわたる影響を与える可能性のある変化であり、AI をより身近で環境に優しいものにする可能性があります。

AIの未来を磨く

Gemma 2 2D は、より効率的なモデルに向かう AI のトレンドの高まりを表しています。大規模な言語モデルの環境への影響とアクセシビリティに対する懸念が高まる中、テクノロジー企業は、日常的なハードウェアで実行できるより小さなシステムを作成する方法を模索しています。

Gemma 2 2D の成功は、モデルの圧縮と蒸留技術の重要性も浮き彫りにしています。大規模なモデルの知識を小さなモデルに効果的に凝縮することで、研究者はパフォーマンスを犠牲にすることなく、よりアクセスしやすい AI ツールを作成できます。

このアプローチは、これらのモデルを実行するために必要な計算能力を削減するだけでなく、大規模な AI システムのトレーニングと実行による環境への影響に関する懸念にも対処します。これは、AI 開発の未来を形作る可能性のある、双方にとってメリットのある状況です。

Gemma 2 2B は、AI に関してはサイズではなく、どのように使用するかが重要であることを証明しています。この小型ながら強力なモデルは、AI に関する私たちの前提に疑問を投げかけ、効率的で強力かつアクセスしやすい新世代の AI システムへの道を開きます。この小さな宝石が AI の世界で輝くことは明らかです。

注目の画像クレジット: Google