科学者たちは、AIを使用して音声サンプルから歌うことができる新しいニューラルネットワークを作成しました。 中国の開発者のアルゴリズムは、人の通常のスピーチの録音に基づいて人の歌の録音を合成するか、またはその逆を実行して、歌に基づいてスピーチを合成することができます。 アルゴリズムの開発、トレーニング、テストについて説明している記事は 公開 arXiv.orgで。

近年、音声合成のためのニューラルネットワークアルゴリズムの開発、 WaveNet 、実在の人物と区別するのが難しいシステムの作成を可能にしました。 たとえば、2018年にはGoogle を示した リアルに話すだけでなく、「ええと」など、音声を検証できる人間の音を挿入できる座席を予約するための音声アシスタント。 その結果、会社は会話の始めにそれが人ではないことを警告するアルゴリズムも教えなければなりませんでした。

他のニューラルネットワークアルゴリズムの場合と同様に、音声合成システムの成功は、主にそれらのアーキテクチャに関係していませんが、主にトレーニングに利用できる大量のデータに関係しています。 歌を合成するためのシステムを作成することは、一見似たような作業ですが、実際には、利用可能なデータの量が大幅に少ないため、はるかに複雑です。

歌唱生成システムに取り組んでいる多くの開発者は、最近、アルゴリズムを教えるために歌唱サンプルの量を減らす道を歩みました。現在、TencentのDong Yuが率いる中国の研究者グループは、音声からリアルな歌唱オーディオ録音を作成できるシステムを作成しました。サンプル。

https://www.youtube.com/watch?v=AnazWGADtnk

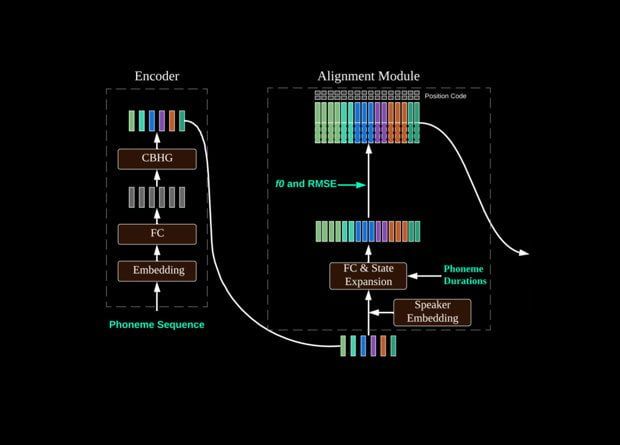

このアルゴリズムは、Tencentの以前の開発であるDurIANニューラルネットワークに基づいており、現実的な合成を行うように設計されています。 ビデオ テキストに基づいて話すプレゼンターと。 現在、彼らはDuarIANの前に新しい音声認識ユニットを配置しました。これは、音声サンプルに基づいて音素を作成します。